Для успешного продвижения в сети важна быстрая индексация сайта. Но иногда с этим возникают проблемы. В статье расскажем, почему так происходит, и предложим 10 способов, благодаря которым можно ускорить попадание страниц в индекс.

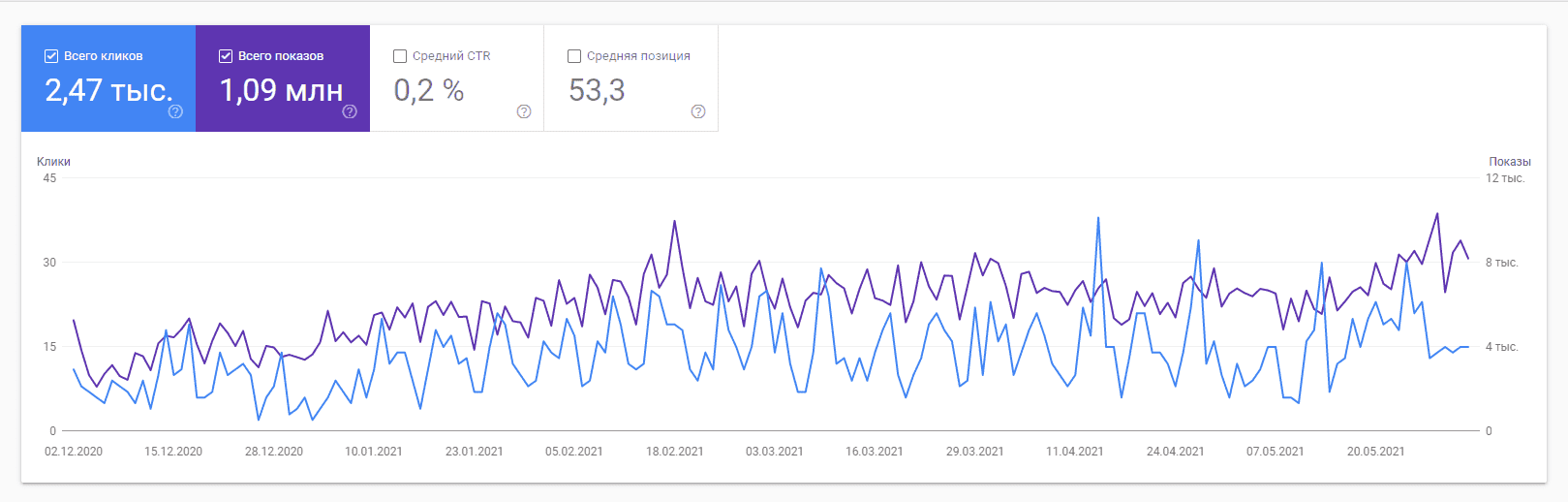

Нормой считается, если новый контент попадает в индекс за 30-40 минут в Google (это примерно, многое зависит от качества и степени раскрученности сайта). Когда процесс затягивается на недели и месяцы или страницы вообще не попадают в поиск, нужно искать причину. Медленная индексация отрицательно влияет на продвижение, к тому же увеличивается риск воровства контента. Перед тем как рассказать, что с этим делать, разберём основные проблемы с индексацией и способы её проверки.

Узнать, находятся ли страницы в индексе, проще всего в панели вебмастера «Гугл». Ещё это можно сделать в SERP, используя оператор «site». Введите в строку поиска «site:URL», в выдаче будут все документы, просканированные ботом. Для массовой проверки индексации можно также использовать специальные плагины и расширения, например, RDS bar.

Если страницы не индексируются вообще, то скорее всего установлен запрет на обход сайта ботами в файле robots.txt или же ресурс попал под фильтры.

Когда документы индексируются, но это происходит слишком долго, то причиной может быть недостаточно частое обновление контента или неправильная внутренняя оптимизация ресурса. Далее рассмотрим действия, которые нужно предпринять при любых проблемах с индексацией.

Текстовый файл robots.txt содержит инструкции для поисковых машин, которые запрещают ботам обход определенных документов и разделов сайта. Если нужно исключить из поиска какие-либо страницы, их закрывают директивой Disallow. Чаще всего это персональные данные пользователей, логи сайта, архивы и т.д. Проверьте, не закрыты ли директивой Disallow подлежащие индексации страницы. Также важно в целом посмотреть корректность синтаксиса robots.txt. Иногда обнаруживаются конфликты директив: боту одновременно разрешают и запрещают обход. Эти и другие недочёты необходимо устранить. Выявить ошибки можно с помощью инструментов «Вебмастера».

Карта сайта – это файл со списком ссылок на страницы ресурса. Она бывает двух форматов: XML и HTML. Первую нужно сделать обязательно, т.к. она передаёт роботам данные о структуре площадки и обеспечивает быструю и корректную индексацию. Создать XML-карту можно с помощью специальных сервисов: XML-Sitemaps, GSitemap Generator, SiteMapXml и т.д.

Sitemap.html больше актуальна для пользователей. Для поисковых ботов практически не имеет значения, но мы рекомендуем сделать и её тоже. Во-первых, она упрощает взаимодействие посетителей с сайтом, во-вторых, это один из приёмов перелинковки.

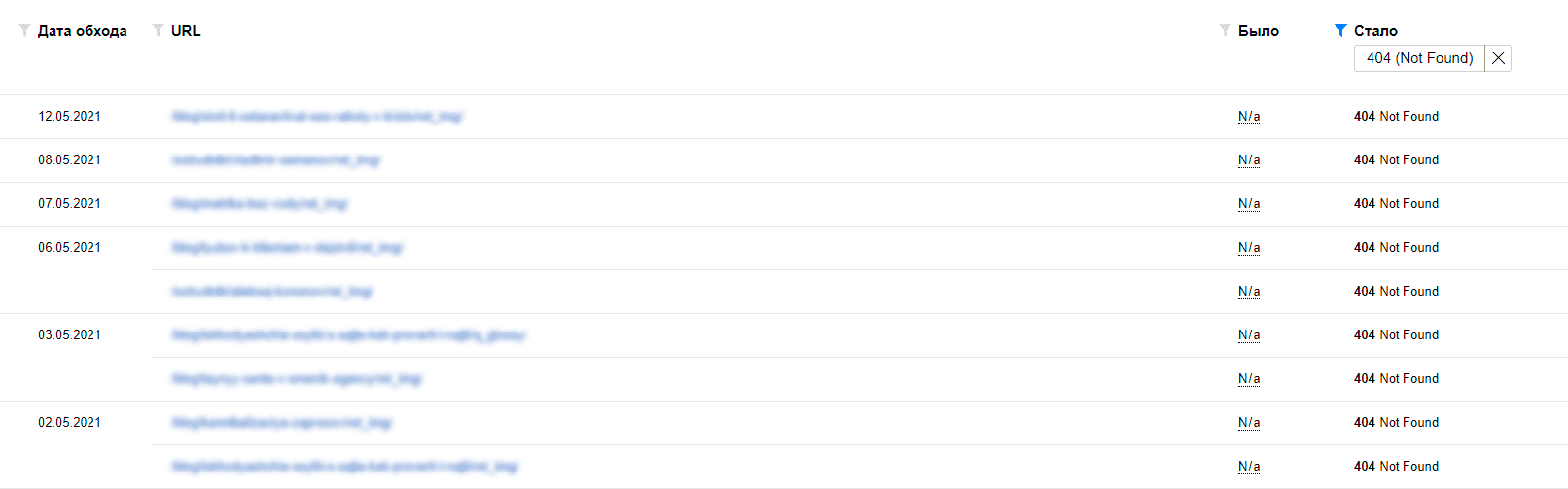

При обращении краулера существующие страницы должны выдавать код ответа 200, несуществующие – 404. При этом если время ответа более 2 секунд, то боты могут его не дождаться и покинуть документ. Это тоже замедляет индексацию. Проверьте код статуса и скорость ответа в инструментах «Вебмастера».

Удалённость документа от главной страницы сайта тоже имеет значение: чем дальше, тем сложнее роботу до него добраться. Оптимальный вариант – это путь от главной длиною в 2-3 клика. Добиться этого можно с помощью создания правильной структуры ресурса и грамотной перелинковки.

Явные и неявные дубли доставляют целый ряд неприятностей: проблемы с внешними URL, замещение оригинала дублирующим документом в поисковых системах, вероятность пессимизации и т.д. Дубли также замедляют и индексацию, поэтому их важно выявить и устранить.

Обнаружить дублирующий контент можно вручную. Но если сайт большой, то удобнее использовать специальные сервисы, например, NetPeak Spider. Устраняют дубли разными способами. Google рекомендует делать это через атрибут Canonical и редирект 301.

Размещайте на сайте уникальный материал: статьи, скопированные с других ресурсов, робот может посчитать дублем, не несущим пользы для читателя. Кроме этого, контент должен быть релевантным и полезным. Пишите для людей, но о SEO тоже не забывайте, ведь по ключевым словам аудитория находит ваш сайт.

Важно также чаще обновлять материал, это увеличивает частоту заходов поисковых машин. Вот несколько рекомендаций для поддержки актуальности ресурса:

- размещайте новый материал хотя бы один раз в неделю;

- обновляйте устаревшие данные;

- ссылайтесь на новый контент со старых разделов;

- используйте заголовки, сообщающие роботам о последних изменениях (Last-Modified и If-Modified-Since).

Старайтесь постоянно улучшать веб-площадку. Даже малейшие изменения в старых статьях (новые фото, несколько новых предложений в тексте) положительно оцениваются краулерами.

После создания сайта зарегистрируйтесь в вебмастере Google. Так вы уведомите поисковых ботов о создании нового ресурса, сможете следить за индексацией страниц и ссылок, выявлять ошибки. При обновлении старого материала или добавлении нового запрашивайте индексирование для конкретного URL, отправляя гуглбота на переобход.

Пинг-сервисы – онлайн-площадки, которые сообщают поисковикам о новой информации в сети, т.е. все изменения на вашем сайте не останутся незамеченными. Перечислим самые популярные:

- Pingomatic.com;

- Auto-ping.com;

- Mypagerank.net;

- Totalping.com;

- Pingler.com;

- Bitacoras.com;

- Ping.in.

Таких сервисов много, но лучше не злоупотреблять – выберите 5-7. Не стоит также добавлять сотни адресов, выберите только самые важные, чтобы не создавать лишнюю нагрузку на сервер.

Социальные сигналы могут значительно ускорить индексацию. В Instagram, Facebook, Twitter, Tumblr, Telegram, Viber можно публиковать анонсы о новых материалах сайта с указанием ссылки. Кроме этого, рекомендуем добавлять кнопки соцсетей под каждой статьей, так пользователи будут помогать роботам находить ваши страницы.

Ещё можно выкладывать анонсы к новым постам в социальных закладках. Для этого есть сервисы: bookmarkee.com, digg.com и т.д. В социальных закладках хорошо работают ключевые слова. Они должны присутствовать в тегах, в заголовке ссылки и её описании.

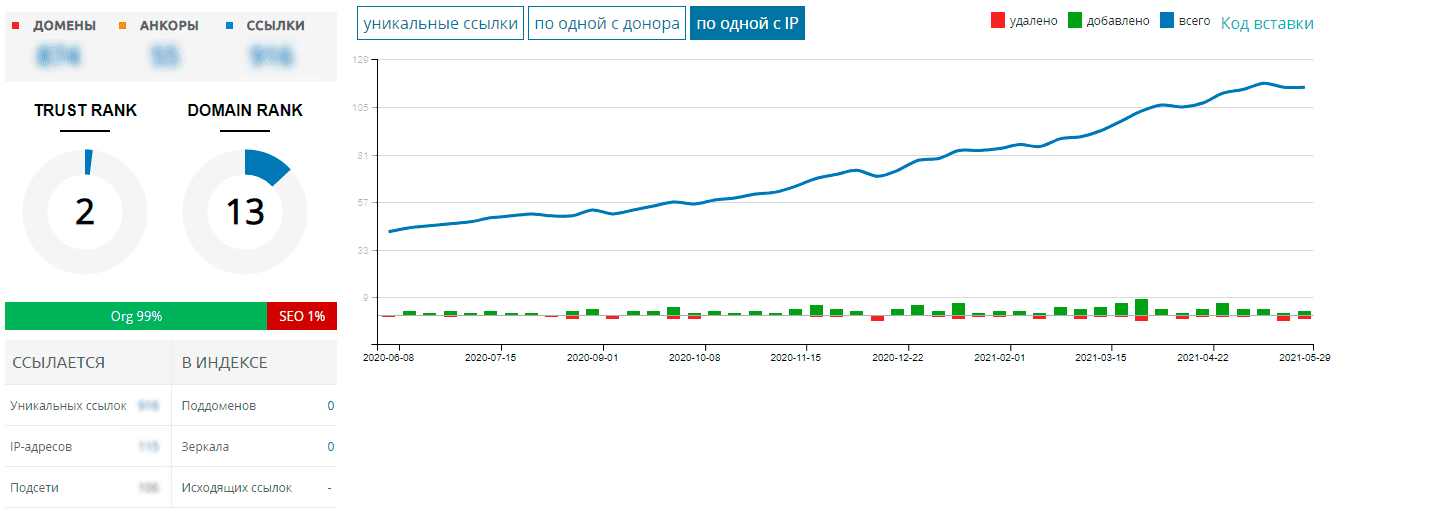

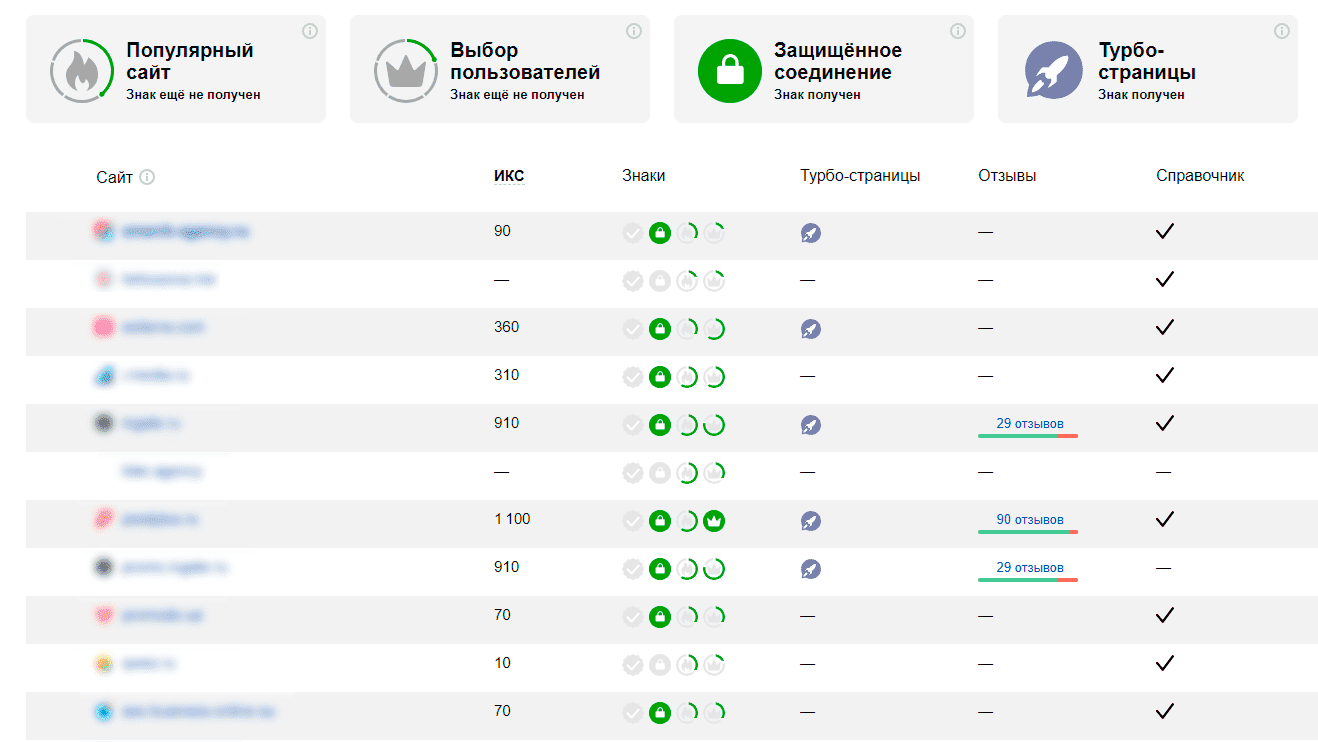

Ссылочный вес также важен для хорошей индексации. Чем больше бэклинков, тем быстрее краулер обнаружит новый материал. Но линки должны быть качественными и располагаться на релевантных трастовых площадках. Также важна естественность ссылочного профиля – делайте его разнообразным, состоящим в основном из безанкорных ссылок.

Все эти методы позволят поисковым машинам быстро и качественно сканировать содержимое ресурса. Благодаря индексации новый материал будет практически мгновенно попадать в выдачу, что приведёт к увеличению трафика и в целом улучшит продвижение.