Современные алгоритмы определения релевантности текста достаточно сложные. Для понимания многих моментов стоит рассмотреть с чего все начиналось. В далеком 20 веке был разработан алгоритм TF-IDF. Алгоритм позволяет оценить важность слова или термина в документе, который является частью определенной коллекции.

TF (term frequency) – частота слова, позволяет оценить важность любого слова в рамках документа. TF – это отношение числа вхождений слова к общему количеству слов в документе. То есть, простыми словами чем чаще слово встречается внутри документа, тем больший условный вес имеет это слово.

IDF (inverse document frequency) – обратная частота документа. Другими словами IDF – инверсия частоты с которой слово встречается не в одном документе, а в пределах всех документов определенной коллекции. Таким образом, IDF уменьшает вес часто употребляемых слов и терминов.

Мы не будем в статье приводить точные формулы и рассчитывать значения коэффициентов. Кто хочет, может более детально ознакомиться с формулами на странице Wikipedia. Также можно почитать про основоположника данной теории – Карен Спарк Джонс.

По работе алгоритма можно сделать простой вывод: максимальный вес получит слово с высокой частотой внутри одного документа и с низкой частотой во всех документах коллекции.

Влияние таких on-page факторов, как простое увеличение ключевых слов довольно мало. Давно такого нет, чтобы кто-то просто увеличил количество ключевых слов или синонимов на странице и обогнал конкурентов в поисковой выдаче. Таким образом, можно сделать вывод, что поисковые системы используют более сложные математические алгоритмы. Учитываются связи между словами, наличие дополнительных слов (LSI) и т.д. То есть, какие слова с каким используется чаще всего, а с каким вообще не используется и т.д.

Больше информации можно найти в статье MOZ и почитать в Wiki про распределение Дирихле.

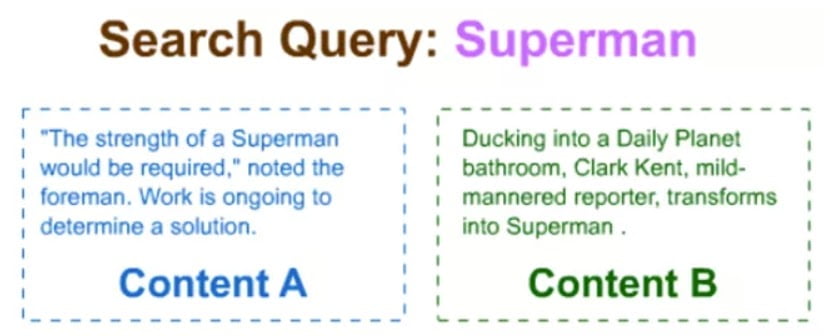

Яркий пример работы поисковых алгоритмов при определении релевантности текста. Поиск по слову Superman.

Применяя статистику о совместном употреблении слов поисковая система поймет, что Кларк Кент и Дейли Планет часто используются со словом Супермен. С точки зрения поисковой системы, второй текст более релевантен, чем первый. Даже несмотря на то, что в первом есть прямое вхождение ключевого запроса и располагается более высоко, чем во втором варианте.

Приведенные примеры не дают ответа на то, как работают алгоритмы поисковых систем при определении релевантности текста. Но эти примеры позволяют понять, что поисковые системы учитывают большое количество различных переменных и имеют сложные математические модели.

То, что на странице 10 раз повторяется ключевое слово, не означает, что текст будет действительно релевантен запросу. Неуместное использование специальных терминов внутри текста также не повысит его вес в глазах поисковых систем. Единственный выход – писать такой текст, который даст все возможные ответы посетителю. Такой текст может написать профессионал в своем деле. Но далеко не каждый профессионал сможет сесть и написать связанный, легко читаемый текст. К тому же стоимость текстов написанных профессионалами будет достаточно высокой.

Как выход из этой ситуации – использование проверенных временем специалистов копирайтеров, которые используя подробные технические задания могут написать качественный текст. Такой текст будет отлично восприниматься поисковыми системами и будет интересен посетителям.

Если вы не уверены в том, что сможете написать подробный хороший текст, доверьте этот вопрос специалистам. Наш отдел копирайтинга создал десятки качественных блогов, которые приносят хороший трафик на сайты.